在本教程中,我们将向您展示如何安装 Apache Debian 11 上的 Hadoop。对于那些不知道的人, Apache Hadoop 是一个基于 Java 的开源软件平台,用于管理大数据应用程序的数据处理和存储。 它旨在从单个服务器扩展到数千台机器,每台机器都提供本地计算和存储。

本文假设您至少具备 Linux 的基本知识,知道如何使用 shell,最重要的是,您将网站托管在自己的 VPS 上。 安装非常简单,假设您在 root 帐户下运行,如果不是,您可能需要添加 ‘sudo‘ 到命令以获取 root 权限。 我将向您展示逐步安装 Apache Debian 11(Bullseye)上的 Hadoop。

安装 Apache Debian 11 Bullseye 上的 Hadoop

第 1 步。在我们安装任何软件之前,重要的是通过运行以下命令确保您的系统是最新的 apt 终端中的命令:

sudo apt update sudo apt upgrade

步骤 2. 安装 Java。

Apache Hadoop 是一个基于 Java 的应用程序。 因此,您需要在系统中安装 Java:

sudo apt install default-jdk default-jre

验证 Java 安装:

java -version

步骤 3. 创建 Hadoop 用户。

运行以下命令以创建一个名为 Hadoop 的新用户:

adduser hadoop

接下来,在创建用户后切换到 Hadoop 用户:

su - hadoop

现在是时候生成 ssh 密钥了,因为 Hadoop 需要 ssh 访问权限来管理其节点、远程或本地机器,因此对于我们的 Hadoop 设置的单个节点,我们配置为可以访问 localhost:

ssh-keygen -t rsa

之后,授予authorized_keys 文件的权限:

cat ~/.ssh/id_rsa.pub >> ~/.ssh/authorized_keys chmod 0600 ~/.ssh/authorized_keys

然后,使用以下命令验证无密码 SSH 连接:

ssh your-server-IP-address

步骤 4. 安装 Apache Debian 11 上的 Hadoop。

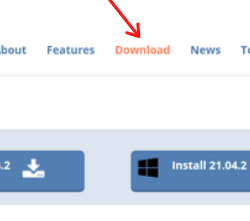

首先,切换到 Hadoop 用户并使用以下命令从官方页面下载最新版本的 Hadoop wget 命令:

su - hadoop wget https://www.apache.org/dyn/closer.cgi/hadoop/common/hadoop-3.3.1/hadoop-3.3.1-src.tar.gz

接下来,使用以下命令提取下载的文件:

tar -xvzf hadoop-3.3.1.tar.gz

解压后,将当前目录更改为 Hadoop 文件夹:

su root cd /home/hadoop mv hadoop-3.3.1 /usr/local/hadoop

接下来,使用以下命令创建一个目录来存储日志:

mkdir /usr/local/hadoop/logs

将 Hadoop 目录的所有权更改为 Hadoop:

chown -R hadoop:hadoop /usr/local/hadoop su hadoop

之后,我们配置 Hadoop 环境变量:

nano ~/.bashrc

添加以下配置:

HADOOP_HOME=/usr/local/hadoop HADOOP_INSTALL=$HADOOP_HOME HADOOP_MAPRED_HOME=$HADOOP_HOME HADOOP_COMMON_HOME=$HADOOP_HOME HADOOP_HDFS_HOME=$HADOOP_HOME YARN_HOME=$HADOOP_HOME HADOOP_COMMON_LIB_NATIVE_DIR=$HADOOP_HOME/lib/native PATH=$PATH:$HADOOP_HOME/sbin:$HADOOP_HOME/bin HADOOP_OPTS="-Djava.library.path=$HADOOP_HOME/lib/native"

Save 和 close 文件。 然后,激活环境变量:

source ~/.bashrc

步骤 5. 配置 Apache Hadoop。

- 配置Java环境变量:

sudo nano $HADOOP_HOME/etc/hadoop/hadoop-env.sh

添加以下配置:

JAVA_HOME=/usr/lib/jvm/java-11-openjdk-amd64 HADOOP_CLASSPATH+=" $HADOOP_HOME/lib/*.jar"

接下来,我们需要下载Javax激活文件:

cd /usr/local/hadoop/lib sudo wget https://jcenter.bintray.com/javax/activation/javax.activation-api/1.2.0/javax.activation-api-1.2.0.jar

验证 Apache Hadoop版本:

hadoop version

输出:

Hadoop 3.3.1

- 配置 core-site.xml 文件:

nano $HADOOP_HOME/etc/hadoop/core-site.xml

添加以下文件:

<configuration> <property> <name>fs.default.name</name> <value>hdfs://0.0.0.0:9000</value> <description>The default file system URI</description> </property> </configuration>

- 配置 hdfs-site.xml 文件:

在配置之前创建一个存放节点元数据的目录:

mkdir -p /home/hadoop/hdfs/{namenode,datanode} chown -R hadoop:hadoop /home/hadoop/hdfs

接下来,编辑 hdfs-site.xml 文件并定义目录的位置:

nano $HADOOP_HOME/etc/hadoop/hdfs-site.xml

添加以下行:

<configuration> <property> <name>dfs.replication</name> <value>1</value> </property> <property> <name>dfs.name.dir</name> <value>file:///home/hadoop/hdfs/namenode</value> </property> <property> <name>dfs.data.dir</name> <value>file:///home/hadoop/hdfs/datanode</value> </property> </configuration>

- 配置 mapred-site.xml 文件:

现在我们编辑 mapred-site.xml 文件:

nano $HADOOP_HOME/etc/hadoop/mapred-site.xml

添加以下配置:

<configuration> <property> <name>mapreduce.framework.name</name> <value>yarn</value> </property> </configuration>

- 配置 yarn-site.xml 文件:

您需要编辑 yarn-site.xml 文件并定义与 YARN 相关的设置:

nano $HADOOP_HOME/etc/hadoop/yarn-site.xml

添加以下配置:

<configuration> <property> <name>yarn.nodemanager.aux-services</name> <value>mapreduce_shuffle</value> </property> </configuration>

- HDFS NameNode 格式。

运行以下命令来格式化 Hadoop Namenode:

hdfs namenode -format

- 启动 Hadoop 集群。

现在我们使用以下命令启动 NameNode 和 DataNode:

start-dfs.sh

接下来,启动 YARN 资源和节点管理器:

start-yarn.sh

您现在可以使用以下命令验证它们:

jps

输出:

[email protected]:~$ jps 58000 NameNode 54697 DataNode 55365 ResourceManager 55083 SecondaryNameNode 58556 Jps 55365 NodeManager

步骤 6. 访问 Hadoop Web 界面。

安装成功后,打开浏览器访问 Apache Hadoop 使用 URL https://your-server-ip-address:9870. 您将被重定向到 Hadoop Web 界面:

导航您的 localhost URL 或 IP 以访问各个 DataNode: https://your-server-ip-address:9864

要访问 YARN 资源管理器,请使用 URL https://your-server-ip-adddress:8088. 您应该看到以下屏幕:

恭喜! 您已成功安装 Hadoop。 感谢您使用本教程安装最新版本的 Apache Debian 11 Bullseye 上的 Hadoop。 如需更多帮助或有用信息,我们建议您查看 官方 Apache 网站.